Do teste multivariante à tomada de decisão por IA

Publicado em 30 de setembro de 2025/Última edição em 30 de setembro de 2025/7 leitura mínima

Victor Kostyuk

Head de engenharia, decisões por IA e aprendizado por reforço, BrazeComo o teste A/B estava muito lento, você optou por realizar testes multivariantes – em vez de testar duas variantes simultaneamente, você testa várias variantes ao mesmo tempo. Os testes multivariantes são de fato mais rápidos que os testes A/B, mas, por outro lado, apresentam todas as desvantagens destes: são mais rápidos, porém ainda muito lentos; não se adaptam às mudanças de comportamento do cliente; e não são personalizados para cada cliente. Há uma forma radicalmente melhor para otimizar campanhas de marketing, a tomada de decisão por IA usando bandidos contextuais.

Neste artigo, explicamos a evolução dos métodos de experimentação em marketing, desde os testes A/B até os testes multivariantes, passando pelos testes de bandidos multi-armados, até chegar aos bandidos contextuais. Vamos entender as vantagens de cada método em relação ao seu antecessor, assim como as desvantagens de cada abordagem. Finalmente apresentamos a forma como a Braze usa e melhora os bandidos contextuais para obter personalização individual verdadeira.

Testes multivariantes

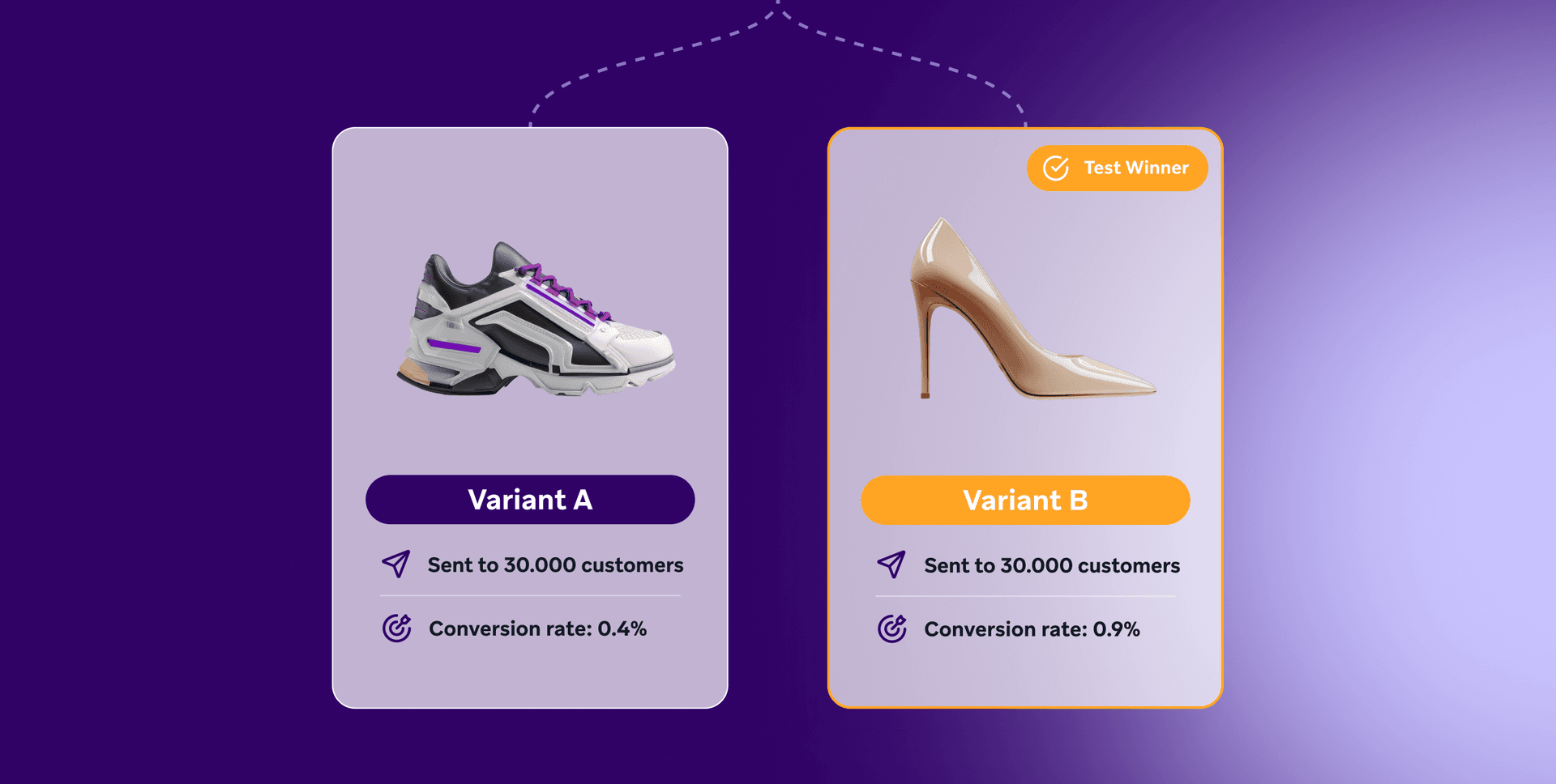

Ao aplicar um teste A/B, você compara duas variantes atribuindo aleatoriamente metade do seu público-alvo a cada variante, enviando a mensagem de marketing correspondente e comparando o desempenho das variantes na sua métrica de resultado, por exemplo, a taxa de conversão. Por exemplo, digamos que você quer saber que sapato incluir em uma oferta de email.

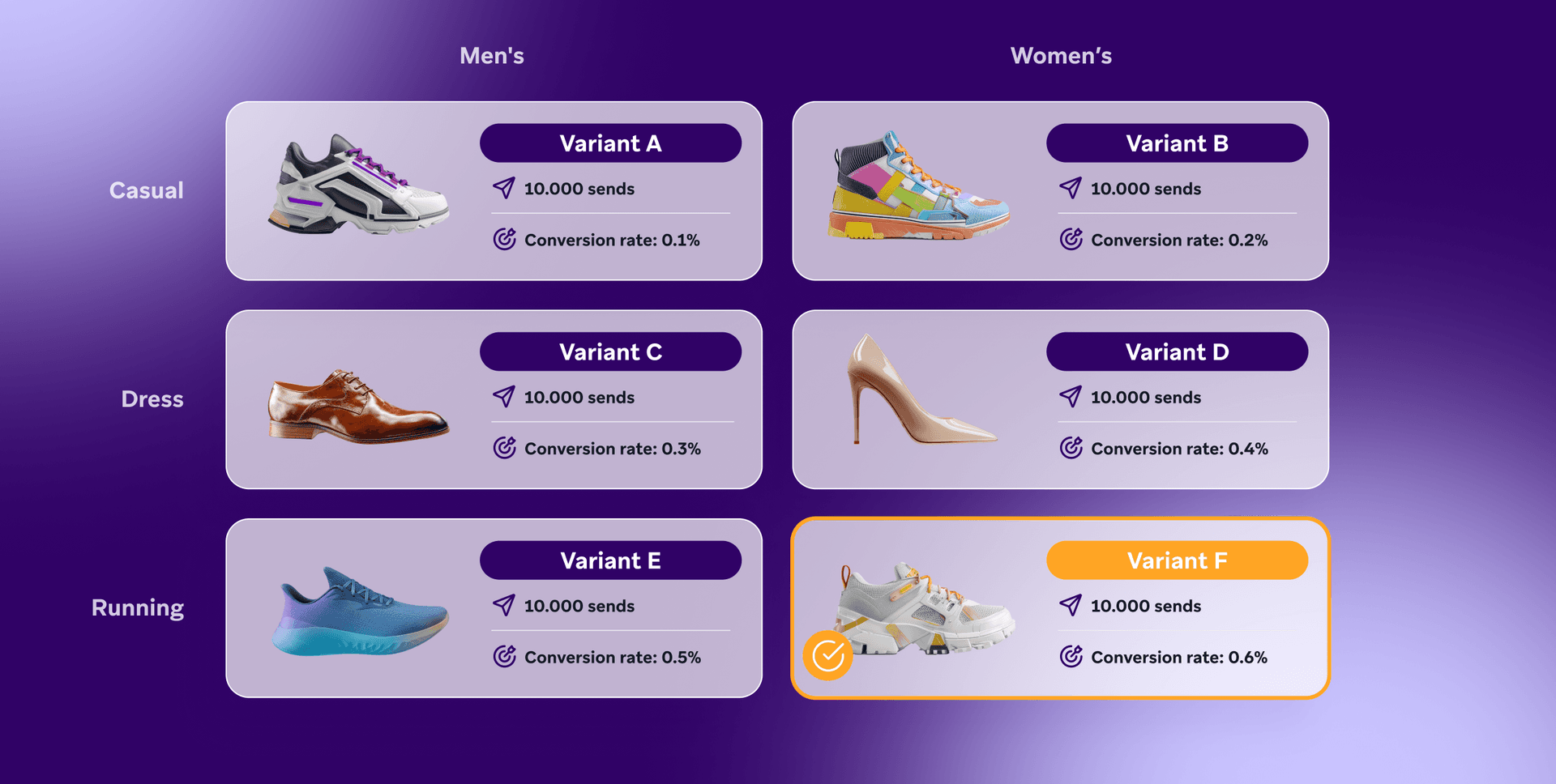

Você tem mais de dois modelos de sapatos para oferecer, então, com uma abordagem de teste A/B, você precisa continuar testando mais sapatos, uns contra os outros – um processo muito lento e trabalhoso. Com o teste multivariante, você testa todas as suas variantes de uma vez:

Teste multivariante é essencialmente um teste A/B aplicado paralelamente e não sequencialmente. Essa abordagem paralela oferece economias de tempo significativas em relação ao teste A/B tradicional, já que você pode testar muitas variáveis simultaneamente, em vez de aplicar testes separados, um depois do outro.

No entanto, essa eficiência tem um preço. Como o público total é dividido igualmente entre todas as combinações de variações (2 gêneros x 3 estilos = 6 combinações no exemplo acima), pode ser difícil alcançar significância estatística se houver muitas combinações.

Para os profissionais de marketing, isso apresenta um dilema:

- Espera mais para coletar dados suficientes para garantir que os resultados sejam confiáveis (sinal) e não apenas flutuações (ruído).

- Atue rapidamente para implementar o que parece ser a melhor opção com base em dados iniciais, que podem não ser confiáveis.

Quanto mais combinações você testar, menor fica cada grupo, exacerbando esse desafio. Por exemplo, se você tiver 60.000 clientes e testar 6 combinações, cada combinação só será testada em 10.000 clientes. Se você aumentar para 12 combinações, o número cai para 5.000 clientes por combinação, tornando ainda mais difícil alcançar significância estatística em um período razoável.

Por causa dessas restrições, o teste multivariante é geralmente usado para um pequeno subgrupo de variações que o profissional de marketing quer usar, em vez de todas as combinações possíveis de cópia de marketing ou produtos. Isso ajuda a manter grupos de tamanhos maiores e atingir significância estatística mais rapidamente, mas reduz o montante de variantes testadas e, dessa forma, a utilidade da técnica.

Outra limitação crucial do teste multivariante é sua natureza estática. Quando você aplica seu teste e determina um “vencedor”, esse resultado é fixado. Mas as preferências e os comportamentos do cliente mudam com o tempo. Uma variante que tem bom desempenho hoje pode não ser a melhor escolha em um mês ou dois. Os testes multivariantes tradicionais não levam em conta essas mudanças, a não ser que você execute novos testes continuamente, o que pode ser demorado e exigir muitos recursos.

É nessa situação que métodos mais avançados como bandidos multi-armados e bandidos contextuais se destacam.

Bandidos multi-armados

Como os testes multivariantes dividem o público igualmente entre diferentes variantes, o experimento pode ser bastante ineficiente em termos de maximização de conversões. Cada variante é enviada para o mesmo número de clientes (10.000 no exemplo acima), mesmo que esteja claro a partir dos primeiros 1.000 envios que uma variante é muito pior que outra. Bandido multi-armado (MAB) é um algoritmo que eficientemente aloca envios para cada variante com base na probabilidade de que a variante seja a melhor. Assim, a MAB é significativamente mais eficiente para identificar a melhor combinação do que um teste multivariante. Isso não significa que o MAB enviará apenas a variante que considera ser a melhor no momento – MABs equilíbram a exploração, enviando a variante que considera ser a melhor atualmente, com exploração, enviando outras variantes para melhorar sua estimativa de qualidade.

Isso indica outra vantagem de um MAB em relação ao teste multivariante: um MAB experimenta continuamente. Um MAB observará se, com o tempo, uma variante que inicialmente apresentava baixo desempenho torna-se mais eficaz e, consequentemente, passa a ser enviada com maior frequência, proporcionalmente ao aumento do seu desempenho. Então, a variante que um MAB considera como a melhor e a distribuição de variantes que ele envia podem mudar com o tempo.

Os MABs são excelentes para encontrar o vencedor global – a variante com melhor desempenho para toda uma população de clientes ou um segmento – e para se ajustar conforme o "vencedor" muda ao longo do tempo. Mas MBAs têm uma limitação fundamental: são incapazes de personalizar. Um MAB trata cada variante com a qual experimenta como uma caixa preta (por exemplo, não sabe se um sapato é semelhante a outro, então é mais provável que tenham desempenho semelhante) e trata todos os clientes da mesma forma. No entanto, nem os clientes nem as variantes são todos iguais!

Bandidos contextuais

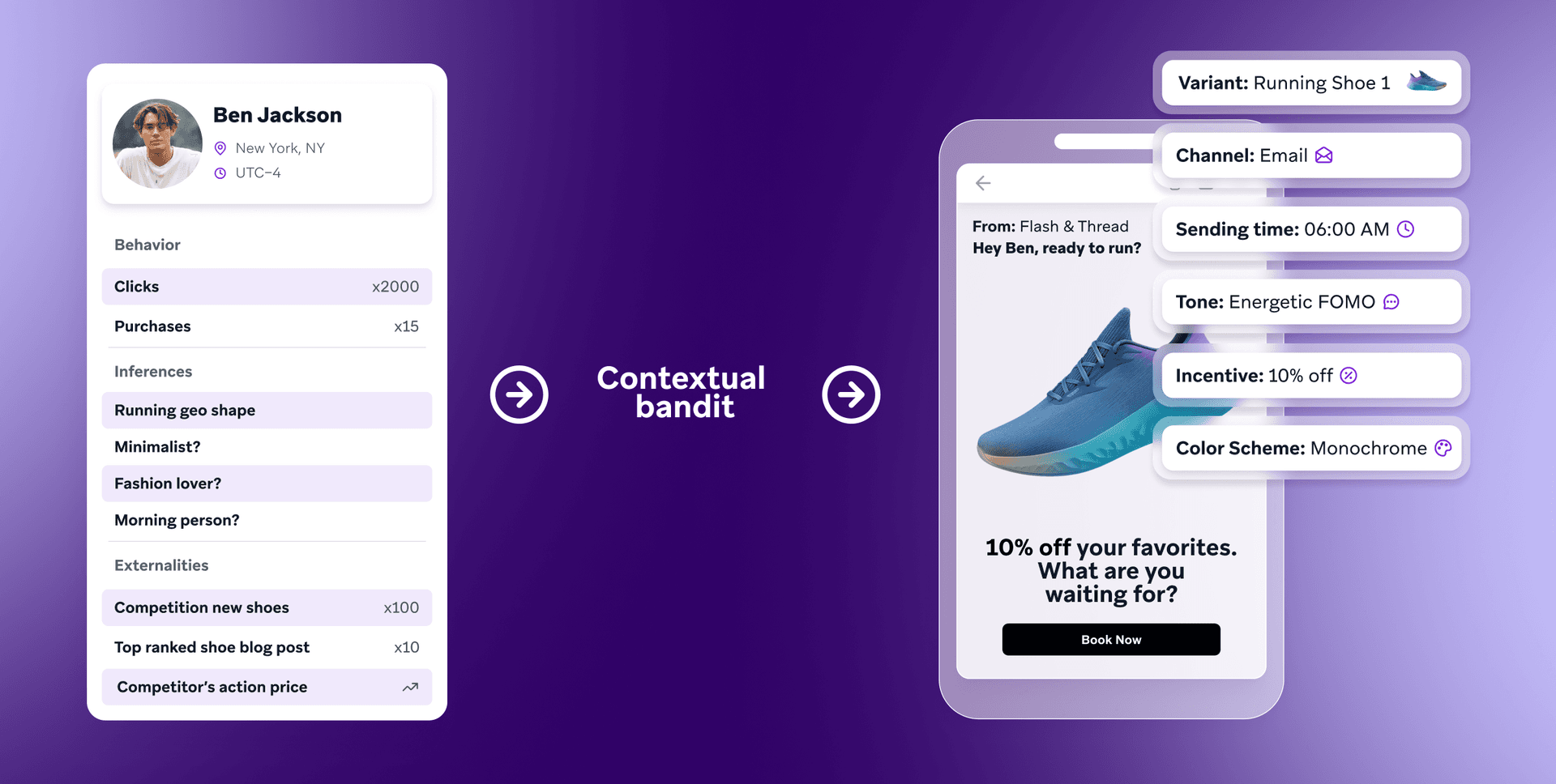

Diferentemente dos MABs, bandidos contextuais são algoritmos que usam contexto sobre clientes, variantes e o ambiente (p.ex., hoje é um feriado ou fim de semana?) para tomar decisões. Por exemplo, o bandido contextual saberia qual é o estilo de um sapato, e se é um sapato masculino ou feminino. O bandido conheceria também o histórico de compras de um cliente (que estilos de sapatos eles compraram anteriormente). Isso permitirá que o bandido contextual aprenda rapidamente que ofertas têm probabilidade de funcionar para cada cliente.

O bandido contextual não seleciona simplesmente uma variante com base na probabilidade média de conversão dessa variante, mas sim na probabilidade de conversão em si para um cliente em particular em um determinado ambiente (e.g., em uma manhã de sábado).

Além do mais, o bandido contextual consegue generalizar entre variantes. Por exemplo, se um novo tênis de corrida for lançado e adicionado como opção, o algoritmo usará o fato de que seu estilo é "tênis de corrida" e aproveitará o conhecimento adquirido sobre tênis de corrida para recomendar o novo tênis. Assim, é muito mais aplicável para os casos de uso de marketing, onde novas variantes aparecem o tempo todo.

Bandidos contextuais apresentam desvantagens: são mais complexos de implementar e manter do que os bandidos multi-armados (MABs), exigem dados atualizados sobre os clientes e, embora consigam lidar com um conjunto muito maior de variantes do que os métodos anteriores, ainda são afetados por grandes coleções de variações.

Tomada de decisão por IA: como a Braze usa e aprimora os bandidos contextuais

Para aumentar a eficiência da amostra, ou seja, a rapidez com que o modelo aprende com dados limitados, nós da Braze usamos uma ”comunidade de bandidos” -- Os agentes de tomada de decisão por IA que dividem a recomendação em dimensões separadas (por exemplo, dia da semana, horário do dia, canal, criativo, oferta), com um bandido contextual separado. tomando decisões em cada uma desses dimensões.

Para saber mais sobre a tomada de decisão por IA, confirma nossos documentos técnicos na nossa comunidade de bandidos.

Tags relacionadas

Be Absolutely Engaging.™

Cadastre-se para receber novidades regulares da Braze.

Conteúdos relacionados

Artigo32 leitura mínima

Artigo32 leitura mínimaMarketing digital para WhatsApp: saiba tudo sobre o assunto

24 de fevereiro de 2026 Artigo5 leitura mínima

Artigo5 leitura mínimaMensagens personalizadas para WhatsApp: tipos e exemplos

13 de fevereiro de 2026 Artigo7 leitura mínima

Artigo7 leitura mínimaMensagem automática de WhatsApp para clientes: boas práticas

12 de fevereiro de 2026